Data Analytics

„Data is a precious thing and will last longer than the systems themselves.“ – Tim Berners-Lee, inventor of the World Wide Web.

Worum geht es?

Daten sind ein wichtiges Gut in der modernen Zeit.

Um aus Daten Informationen zu gewinnen ist das Persistieren, Migrieren und Umwandeln von Daten meist unumgänglich. Neben der Gestaltung von Prozessen und der Anbindung von Datenquellen an Datenbanken sollte man Aspekte wie Sicherheit, Betrieb, Überwachung und alle anderen empfohlenen Best Practices in Cloud-Umgebungen nicht vernachlässigen.

Wir als tecRacer sind erfahrene Generalisten, haben aber auch spezielle Teams, wie für Data Analytics, um beide Aspekte zusammenzubringen.

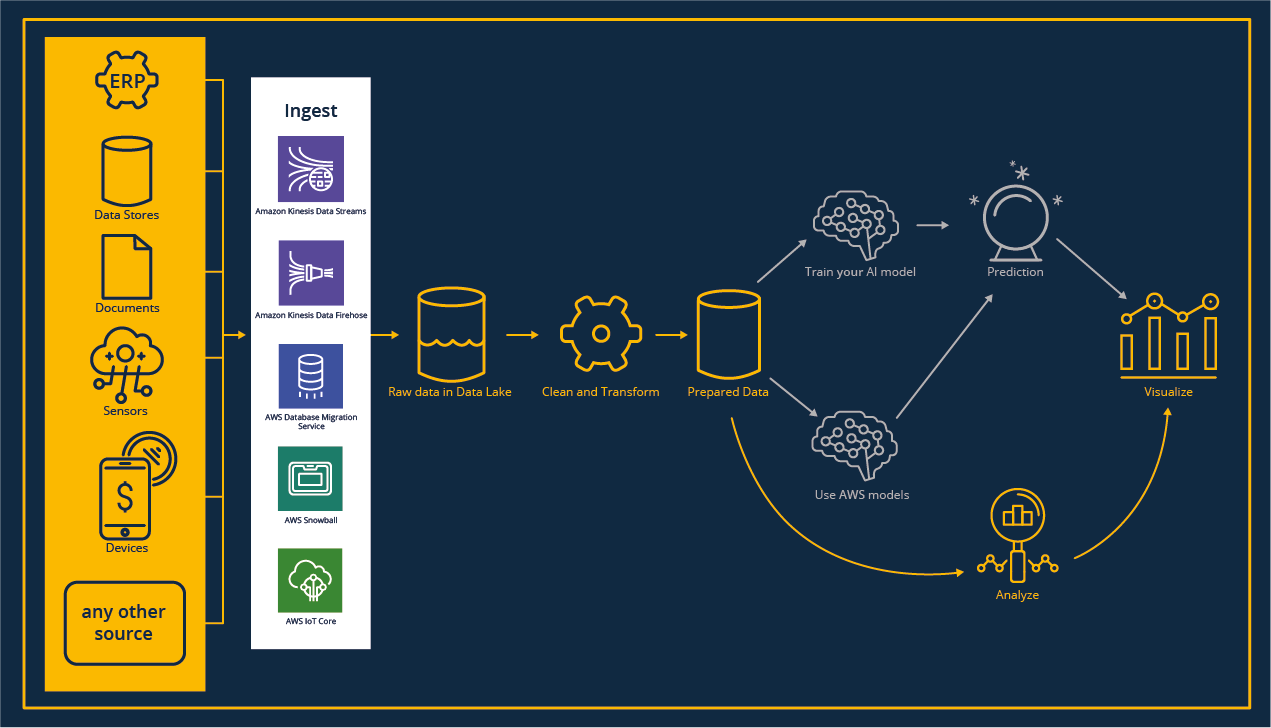

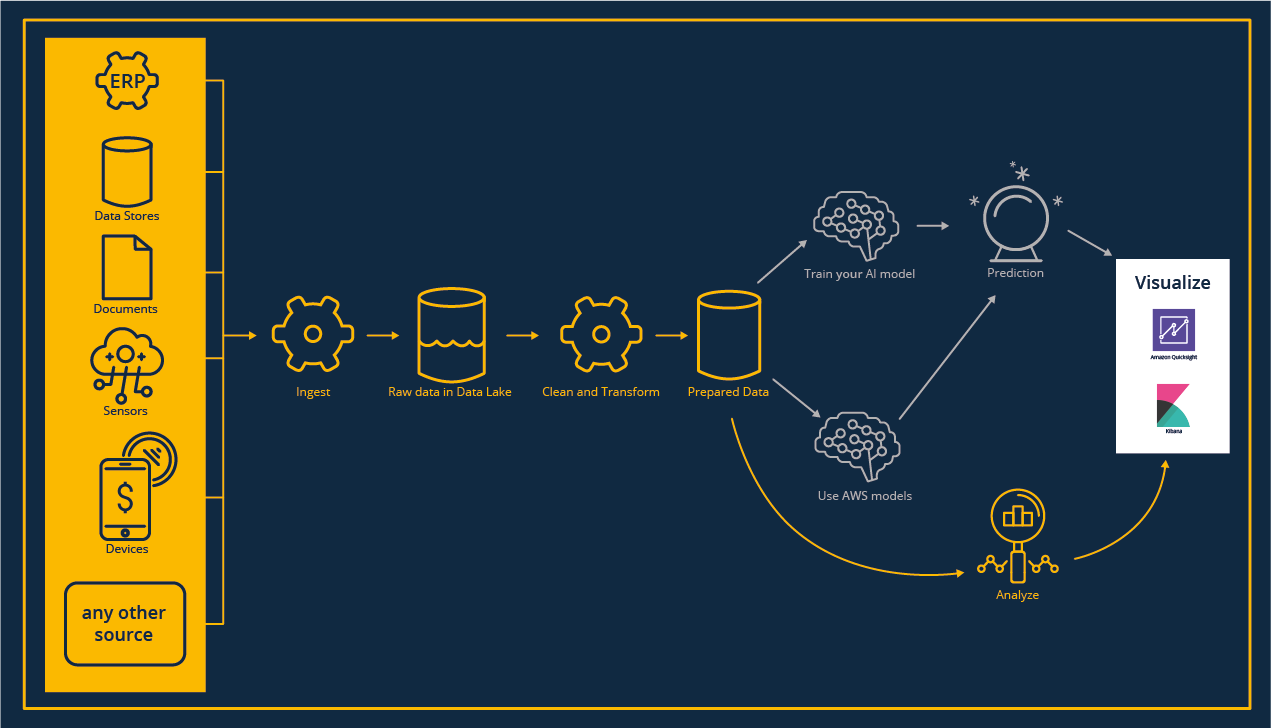

Ingest

Wir leben in einer Welt, in der Daten allgegenwärtig sind und unsere Systeme von ihnen überflutet werden. Um sie nutzbar zu machen und ihr Potenzial zu entfalten, müssen wir sie zunächst erfassen, aufbewahren und zentral zugänglich machen.

Ganz gleich, ob du mit neuen Usecases loslegen willst und dabei vorhandene Daten in die Cloud migrieren musst, oder ob du automatisierte Pipelines einrichten willst, um einen kontinuierlichen Datenfluss in die Cloud-Umgebung herzustellen: der Prozess der Dateneinspeisung ist immer notwendig.

Für jeden Workload, egal ob Streaming, IoT oder Batch-Verarbeitungen gibt es den passenden Service.

Projektreferenz „Ingest“

Siemens AG

Projektziele

Erschaffe deine eigene Datenanalyseplattform.

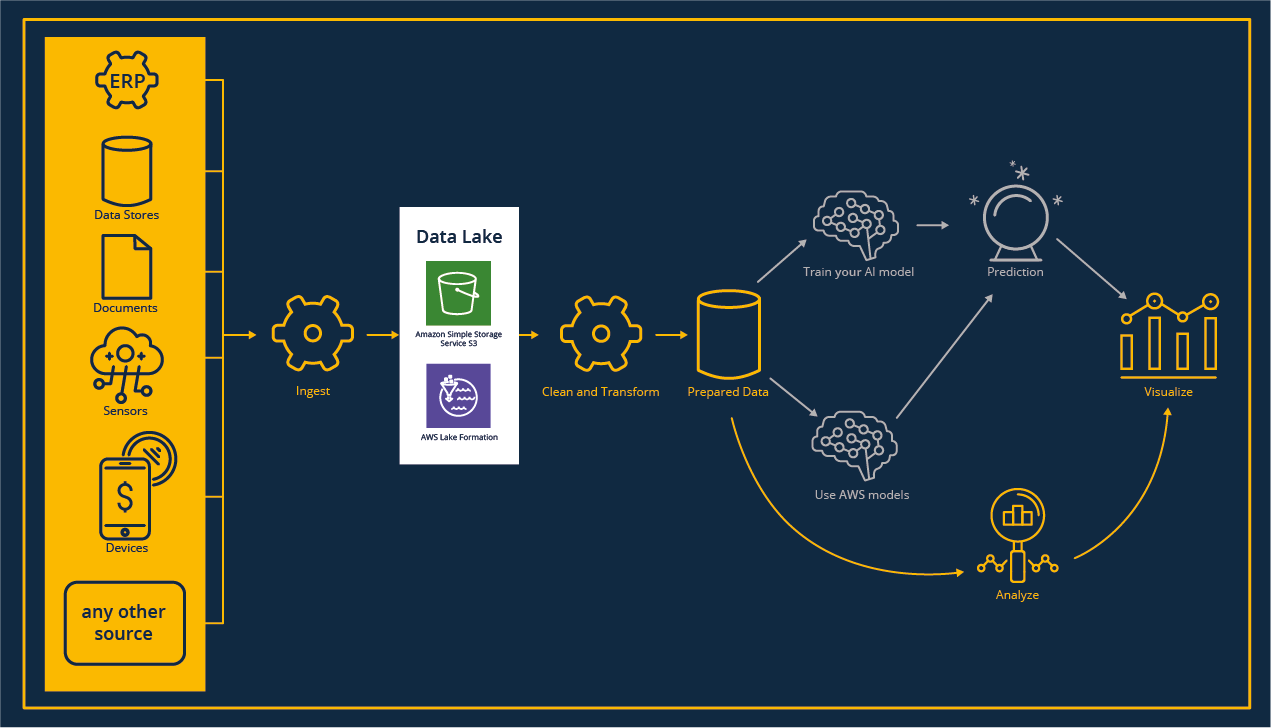

Data Lake

Die Einrichtung eines zentralen Repositorys für Rohdaten führt zu einer Vielzahl von Möglichkeiten für Data Analytics und Machine Learning Anwendungsfälle. Das Data Lake-Konzept bietet viel Flexibilität bei der Erstellung brandneuer Analysen, der Untersuchung von Daten, um Korrelationen zwischen Datensätzen zu finden und dient als Backup im Transformationsprozess, wenn Ausreißer in den Ergebnissen interpretiert werden müssen.

Wenn du an Informationen über Data Lakes interessiert bist, lies bitte unser Whitepaper. Die Nutzung eines Data Lake ist beides: Eine große Chance, aber auch ein Risiko für Dateneigentümer, insbesondere wenn es um GDPR-bezogene Daten geht. Wir, als tecRacer, haben viel Erfahrung mit dem Aufbau eines Data Lakes, der Strukturierung von Datenformaten und dem Zugriff der Daten auf Zeilenebene.

Projektreferenz „Data Lake“

Kontor New Media GmbH

Projektziele

Erstelle deinen Datalake in AWS.

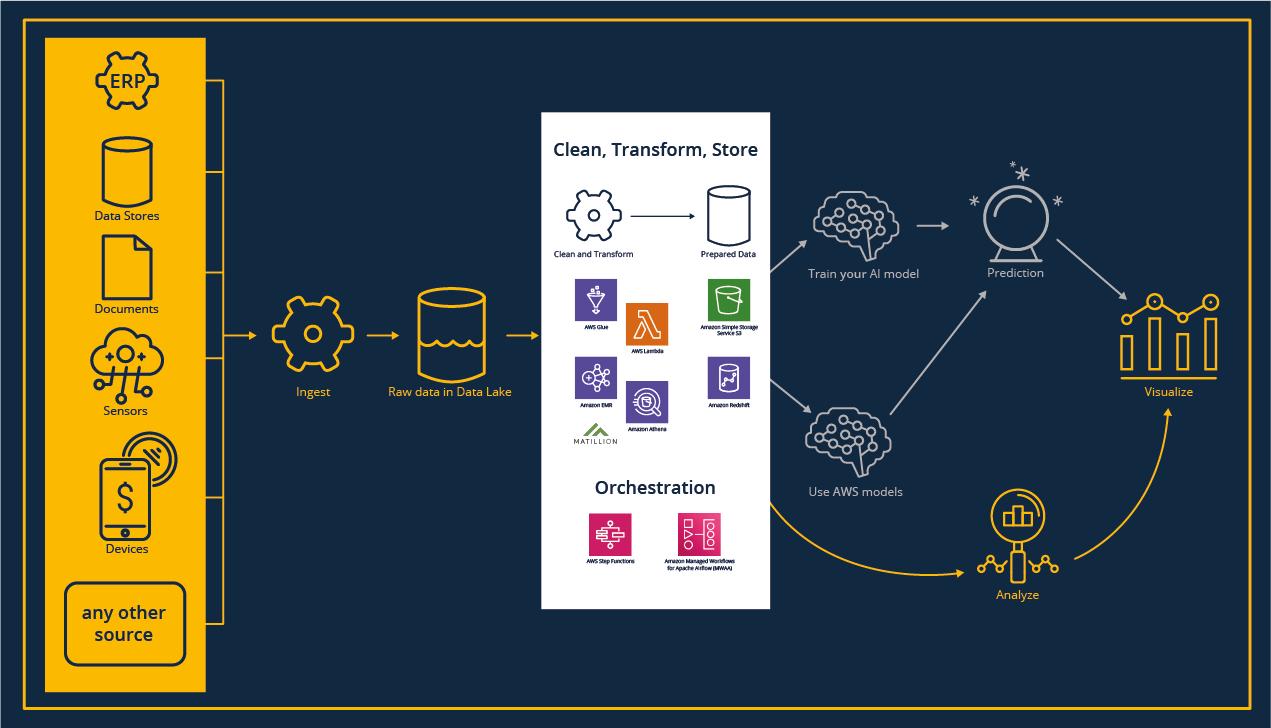

Clean, Transform and Store

Jetzt beginnt der spannende, wenn auch aufwändigste Teil des Analyseprozesses: Die Aufbereitung der Daten für die Visualisierung oder das Modelltraining.

Neben den klassischen Apache Hadoop-bezogenen Workloads mit Jupyter Notebooks, z.B. mit Apache Spark oder serverlosen Funktionen, stehen grafische Werkzeuge wie Drittanbieter-Tools z.B. Matillion ETL zur Verfügung.

Die Datentransformation ist nicht nur hinsichtlich der Erstellung eines geeigneten Data-Warehouse-Modells, der Datenbereinigung und -transformation eine Herausforderung. Sie erfordert auch die Orchestrierung unterschiedlicher Arbeitslasten in Bezug auf Zeitpläne, Reihenfolge der Ausführung und Infrastruktur.

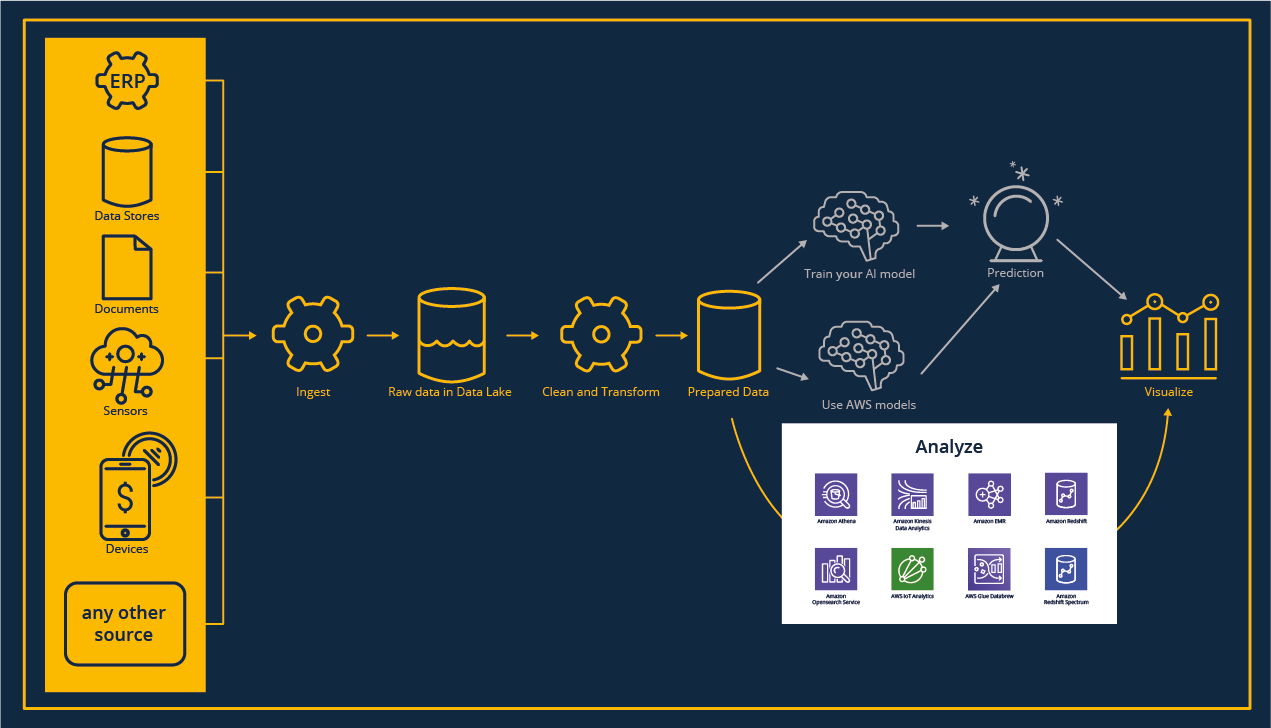

Analyze

Für Analysen ist eine konsistente und geschäftsorientierte Sicht absolut notwendig.

Unterschiedliche Anwendungsfälle erfordern unterschiedliche Zugriffsmuster:

Von der Abfrage eines klassischen Data Warehouse über den Zugriff auf Daten in einem Apache Hadoop-Cluster bis hin zu neuen und spannenden Speicheroptionen wie der Verwendung eines Objektspeichers, oder der Kombination von Daten zwischen diesen – alles ist möglich!

Visualize

Die extrahierten Informationen aus unseren Daten sollen verständlich, zugänglich und lesbar sein.

In diesem letzten Schritt geht es darum, das Wesentliche unserer Daten darzustellen und zu verstehen.

Auch die Verfolgung in Echtzeit über Dashboards ist eine wichtige Funktion.

Was ist eigentlich ein Data Mesh?

Der oben vorgestellte Prozess zeigt ein wesentliches, jedoch nicht vollständiges Bild zur Erstellung von Analysen.

Er beschreibt im Grunde den technischen Prozess um Daten zu analysieren. Hierbei werden organisatorische Strukturen im Unternehmen außer Acht gelassen. Abhängig von diesen und der Unternehmensgröße kann es Sinn ergeben, statt sämtliche Rohdaten des Unternehmens in einem zentralisiertem Data Lake abzulegen und bereitzustellen, die Daten als Produkt zu verstehen und damit dezentral zu halten und aufzubereiten.

Dieses Konzept ist als Data Mesh bekannt. Der wesentliche Unterschied besteht darin, dass Datenbesitzer auch die Verantwortung für das Bereinigen und Bereitstellen der Daten übernehmen. Ein (team-) übergreifendes Regelwerk sichert die Einheitlichkeit und Sicherheit über die gesamte Organisation.

Bei der Wahl der individuell besten Strategie der Datenhaltung unterstützen wir mit unseren Spezialisten von tecRacer sehr gerne.